亚马逊AWS官方博客

新增功能 – AWS Deep Learning Containers

我们希望能让您尽可能方便地了解深度学习并运用到您的应用程序中。如果您知道如何提取大型数据集、训练现有的模型、构建新模型以及执行推理,说明您已经为未来做好了准备!

新推出 Deep Learning Containers

今天我将向大家介绍新推出的 AWS Deep Learning Containers。这些 Docker 映像可以随时与 TensorFlow 或 Apache MXNet 配合使用以进行深度学习训练或推理,对其他框架的支持也将很快推出。客户告诉我们,他们正在使用 Amazon EKS 和 ECS 将 TensorFlow 工作负载部署到云中,并要求我们让这一任务变得尽可能简单直接,为此我们构建了这些容器。虽然我们已经做到了客户的要求,但仍对这些映像进行优化以在便于在 AWS 上使用,希望能够减少训练时间,提高推理性能。

这些映像已经过预先配置和验证,让您可以在几分钟内完成 Amazon ECS、Amazon Elastic Container Service for Kubernetes 和 Amazon Elastic Compute Cloud (EC2) 上的自定义环境和工作流程设置,从而专注于深度学习! 您可以在 AWS Marketplace 和 Elastic Container Registry 找到它们并免费使用。这些映像可以照原样使用,也可以通过添加额外的库或文件包进行自定义。

现提供多种 Deep Learning Containers,具体名称取决于下列因素(并非所有组合都可使用):

- 框架 – TensorFlow 或 MXNet。

- 模式 – 训练或推理。您可以在单个节点上或多节点集群上进行训练。

- 环境 – CPU 或 GPU。

- Python 版本 – 2.7 或 3.6。

- 分布式训练 – Horovod 框架的可用性。

- 操作系统 – Ubuntu 16.04。

Deep Learning Containers 的使用

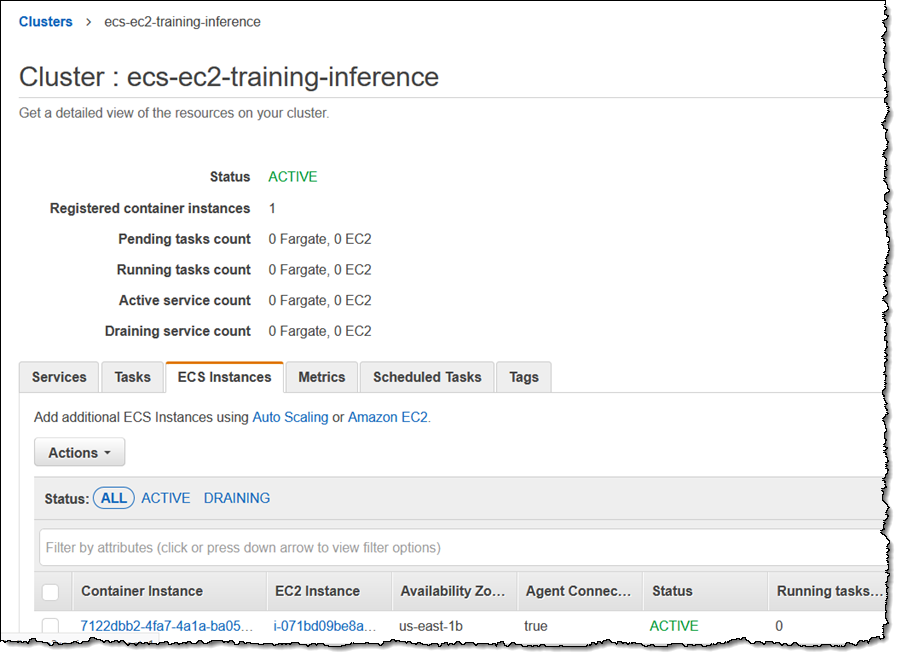

为了使用 AWS Deep Learning Container,我使用一个 p2.8xlarge 实例创建了一个 Amazon ECS 集群:

我验证了该集群正在运行,并确认 ECS 容器代理已激活:

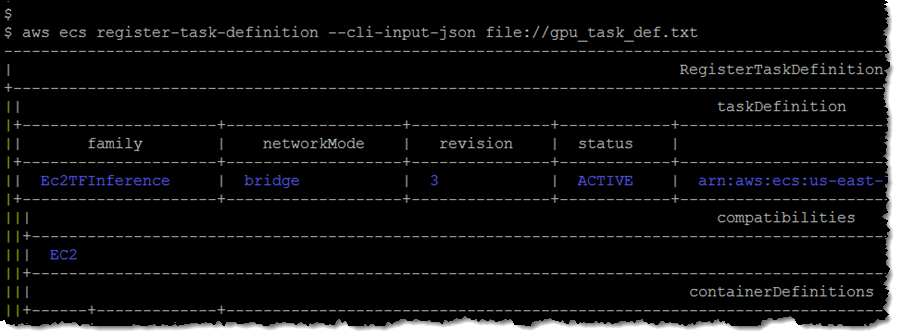

然后我在一个文本文件 (gpu_task_def.txt) 中创建了一条任务定义:

我注册了该任务定义,然后记住了修订版次 (3):

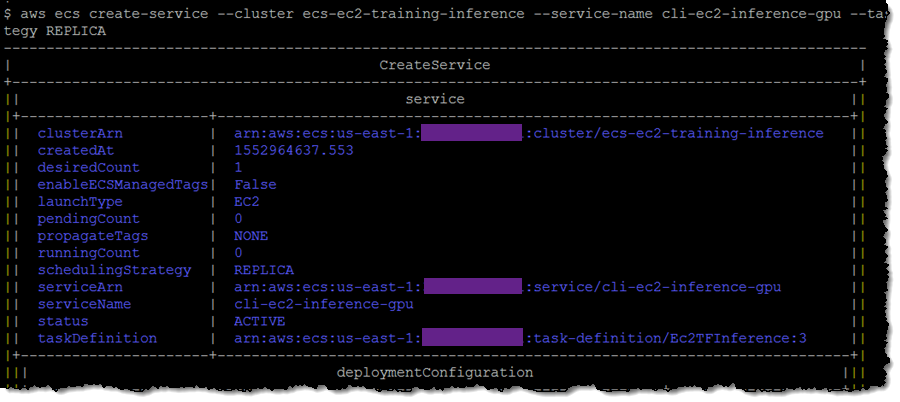

然后,我使用该任务定义和修订版次创建了一个服务:

然后,我使用该任务定义和修订版次创建了一个服务:

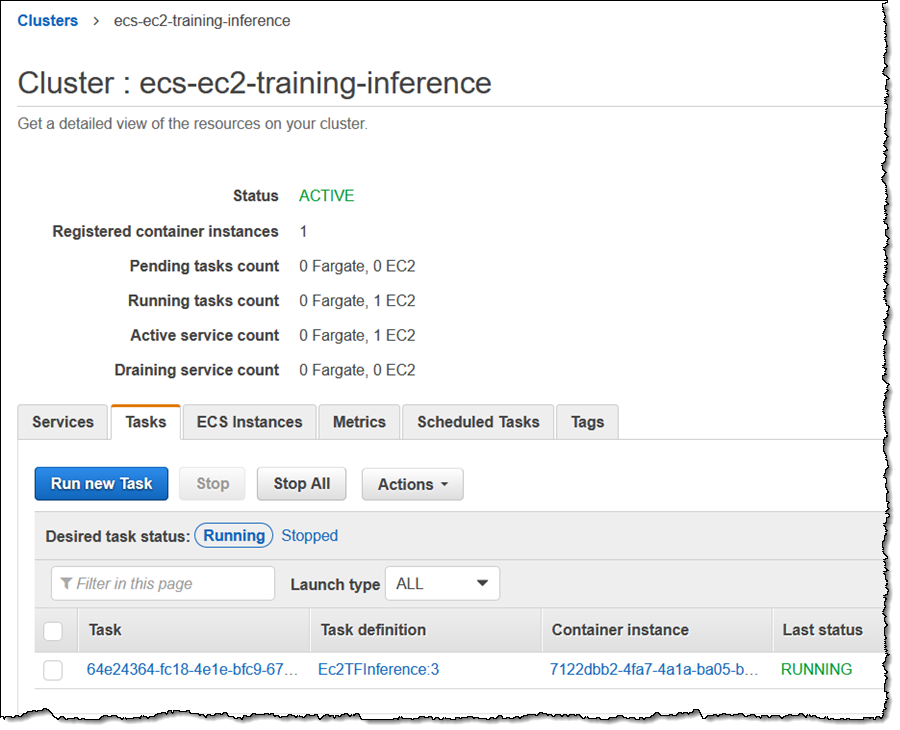

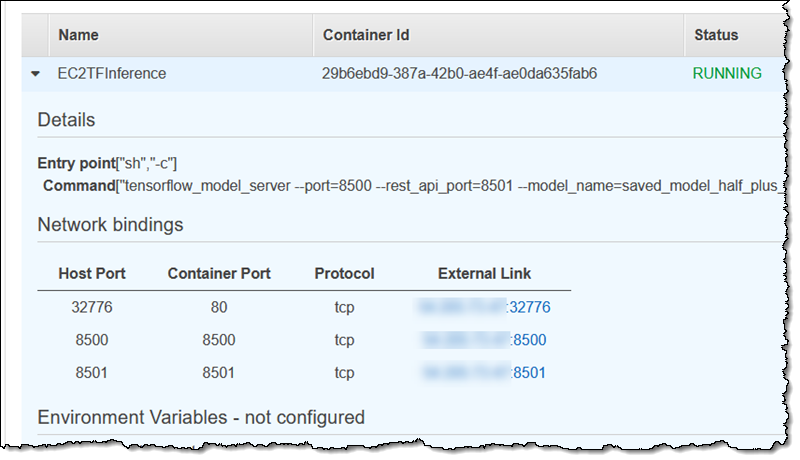

我通过控制台导航至该任务:

然后我找到了端口 8501 的外部链接:

然后我运行了三个推理(此特定模型使用如下函数进行训练:y = ax + b,其中 a = 0.5,b = 2):

正如您可以看出,推理预测输入值为 1.0、2.0 和 5.0 时,值将为 2.5、3.0 和 4.5。这是一个非常非常简单的示例,但也很好地说明了通过 Deep Learning Containers,在 ECS 中使用预先训练的模型来执行推理的方法。您还可以启动用于训练用途的模型,执行训练,然后运行一些推理。